تناقض بين الذكاء الاصطناعي والمهن الإبداعية: إشارات إلى الأيام السيئة لوادي السيليكون

بوابة الذكاء الاصطناعي - وحدة المتابعة

“اسرع وأتلف الأشياء” هي شعار لا يزال يطارد قطاع التكنولوجيا، بعد حوالي 20 عامًا من ابتكاره من قبل مارك زوكربيرغ الشاب.

قالت محررة شئون التكنولوجيا في BBC الكاتبة Zoe Kleinman هذه الكلمات أصبحت رمزًا لوادي السيليكون في أسوأ حالاته – مزيج من الطموح الرحيم والغطرسة المذهلة تقريبًا – ابتكار مدفوع بالربح دون الخوف من العواقب.

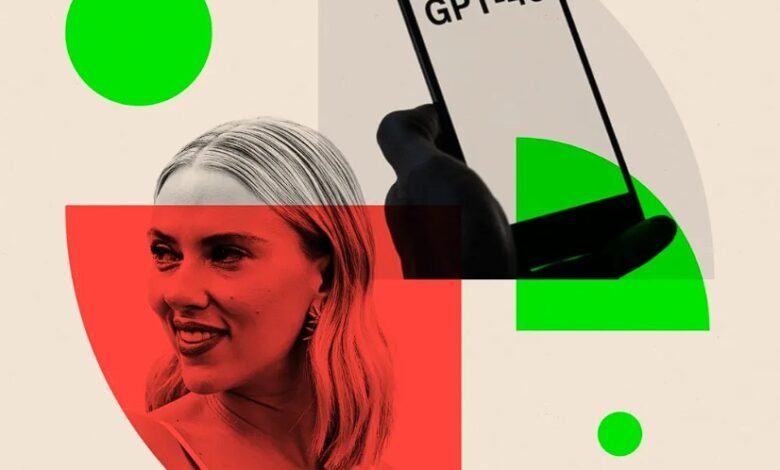

تذكرت هذه العبارة هذا الأسبوع عندما تصادم الممثل سكارليت جوهانسون مع OpenAI. زعمت السيدة جوهانسون أن كلاً منها ووكيلها رفضا أن تكون صوتها لمنتجها الجديد لـ ChatGPT – ومع ذلك عندما تم الكشف عنه، بدا أنه يشبه صوتها تمامًا. ينفي OpenAI أن هذا كان تقليدًا متعمدًا.

إنها توضيح كلاسيكي تمامًا لما تقلق بشأنه الصناعات الإبداعية – أن تتم محاكاتهم وأن يتم استبدالهم في النهاية بالذكاء الاصطناعي.

الأسبوع الماضي، كتبت شركة Sony Music ، أكبر ناشر موسيقي في العالم، إلى Google و Microsoft و OpenAI تطالبهم بمعرفة ما إذا كان أي من أغاني فنانيهم قد استخدم لتطوير أنظمة الذكاء الاصطناعي، وقالوا إنه لم يكن لديهم أي إذن للقيام بذلك.

هناك صدى في كل هذا لعمالقة وادي السيليكون الماضي. البحث عن الغفران بدلاً من الإذن كخطة عمل غير رسمية.

ولكن شركات التكنولوجيا لعام 2024 حريصة للغاية على التباعد عن هذه السمعة.

لم يكن OpenAI مشكلاً من هذا القالب. في الأصل، تم إنشاؤها كمنظمة غير ربحية ستستثمر أي أرباح إضافية في العمل.

في عام 2019، عندما شكلت ذراعًا موجهًا نحو الربح، قالوا إن الجانب الموجه نحو الربح سيقوده الجانب غير الربحي، وسيتم فرض حد أقصى على العوائد التي يمكن أن يحققها المستثمرون.

لم يكن الجميع سعداء بهذا التغيير – قيل إنه كان السبب الرئيسي وراء قرار المؤسس المشارك الأصلي إيلون ماسك للرحيل.

عندما تم إقالة الرئيس التنفيذي لـ OpenAI سام ألتمان بشكل مفاجئ من قبل مجلس إدارته في أواخر العام الماضي، كانت إحدى النظريات أنه أراد الابتعاد أكثر عن المهمة الأصلية. لم نعرف ذلك على وجه اليقين أبدًا.

ولكن حتى إذا أصبحت OpenAI أكثر تركيزًا على الربح، فلا تزال عليها مواجهة مسؤولياتها.

في عالم صنع السياسات، هناك شبه إجماع على أنه بحاجة إلى وضع حدود واضحة لإبقاء شركات مثل OpenAI في المسار الصحيح قبل وقوع كارثة.

حتى الآن، لعبت عمالقة الذكاء الاصطناعي لعبة الكرة على الورق. في قمة السلامة الاصطناعية الأولى في العالم قبل ستة أشهر، وقع عدد من قادة التكنولوجيا على تعهد طوعي لإنشاء منتجات مسؤولة وآمنة ستعظم فوائد تكنولوجيا الذكاء الاصطناعي وتقلل من مخاطرها.

كانت هذه المخاطر، التي حددها منظمو الحدث في البداية، المواد الخام الحقيقية للكوابيس. عندما سألت آنذاك عن التهديدات الأكثر واقعية للناس الناجمة عن أدوات الذكاء الاصطناعي التي تميز ضدهم أو تستبدلهم في وظائفهم، قيل لي بحزم أن هذا الاجتماع كان مخصصًا لمناقشة أسوأ السيناريوهات المحتملة فقط – هذا كان منطقة ترمينيتور ويوم الدين وخروج الذكاء الاصطناعي عن السيطرة والإبادة البشرية.

بعد ستة أشهر، عندما اجتمع القمة مرة أخرى، تم إزالة كلمة “السلامة” تمامًا من عنوان المؤتمر.

الأسبوع الماضي، خلصت مسودة تقرير حكومي بريطاني من مجموعة من 30 خبيرًا مستقلاً إلى أنه “لا يوجد دليل حتى الآن” على أن الذكاء الاصطناعي يمكن أن ينتج سلاحًا بيولوجيًا أو ينفذ هجومًا إلكترونيًا متطورًا. وقيل إن احتمالية فقدان البشر السيطرة على الذكاء الاصطناعي “محل جدل شديد”.

هذا المحتوى تم باستخدام أدوات الذكاء الاصطناعي